“Zahlen als neue Ressource: Entscheidungsfinder:innen optimieren Märkte durch datengestützte Erkenntnisse.”

Daten schaffen Märkte — und zwar schnell, lautlos und oft an Orten, an denen niemand zuvor Handel vermutet hätte: von Standortdaten für Lieferketten bis zu anonymisierten Gesundheitsprofilen, die Versicherungsprodukte beeinflussen. Wer die Mechanik dieser neuen Märkte versteht, versteht, wie aus Zahlen wirtschaftliche Wertschöpfung, Wettbewerbsfähigkeit und sogar politische Macht entsteht.

Ein *Datenmarkt* ist kein physischer Marktplatz, sondern ein ökonomisches Ökosystem, in dem Daten als handelbare Güter erzeugt, bewertet, angeboten und nachgefragt werden. Anders als klassische Waren folgen Daten besonderen Regeln: sie sind *reproduzierbar*, können gleichzeitig mehrfach genutzt werden und gewinnen oft an Wert, je mehr sie mit anderen Datensätzen verknüpft werden. Für Entscheidungsfinder:innen bedeutet das: Daten sind keine bloßen Inputs, sondern strategische Vermögenswerte.

Die wichtigsten Akteure in Datenmärkten lassen sich in folgende Gruppen unterteilen:

- Produzenten – Unternehmen, Plattformen und Geräte, die Rohdaten generieren (z. B. IoT-Sensoren, Apps, Transaktionssysteme).

- Kuratoren und Anreicherer – Anbieter, die Daten bereinigen, anreichern, normalisieren und Metadaten bereitstellen.

- Marktplätze und Vermittler – Plattformen, die Angebot und Nachfrage zusammenbringen, Vertrags- und Zahlungsabwicklung übernehmen sowie Qualitätssignale bereitstellen.

- Käufer – Unternehmen, Forschungsinstitutionen oder Behörden, die Daten für Analyse, Produktentwicklung oder Entscheidungsfindung nutzen.

- Regulatorische Instanzen und Standardisierer – schaffen Rahmenbedingungen für Datenschutz, Eigentum und Interoperabilität.

Wesentliche Typen von Datenmärkten sind:

- Offene Marktplätze mit frei verfügbaren oder Community-geteilten Datensätzen.

- Kommerzielle B2B-Marktplätze, auf denen standardisierte Datensätze verkauft oder lizenziert werden.

- Intermediierte Ökosysteme, in denen Plattformbetreiber als Gatekeeper agieren und starke Netzwerk- sowie Aggregationsvorteile erzielen.

- Dezentrale Datenbörsen, die Blockchain- oder Smart-Contract-Technologien nutzen, um Transaktionen und Provenienz nachzuverfolgen.

Für die Funktionsfähigkeit solcher Märkte sind mehrere ökonomische und technische Faktoren entscheidend:

- Qualität und Vertrauen: Daten müssen valide, aktuell und nachvollziehbar sein. Metadaten, Provenienzangaben und Qualitätsmetriken sind oft wichtiger als der Rohdatensatz selbst.

- Liquidität: Ein Markt funktioniert nur, wenn Angebot und Nachfrage in ausreichender Masse vorhanden sind. Standardisierung und einfache Zugangsmodelle erhöhen die Liquidität.

- Interoperabilität: Gemeinsame Formate, APIs und Taxonomien reduzieren Reibungsverluste und ermöglichen Cross-Dataset-Analysen.

- Preismechanismen: Preise können als Abonnement, Pay-per-Use, Auktionen oder nutzungsbasierte Lizenzen gestaltet sein. Dynamische Preismodelle berücksichtigen Seltenheit, Aktualität und Exklusivität.

- Netzwerkeffekte: Je mehr Teilnehmer ein Marktplatz hat, desto mehr Wert entsteht für jeden weiteren Teilnehmer — sowohl für Datenanbieter als auch für Käufer.

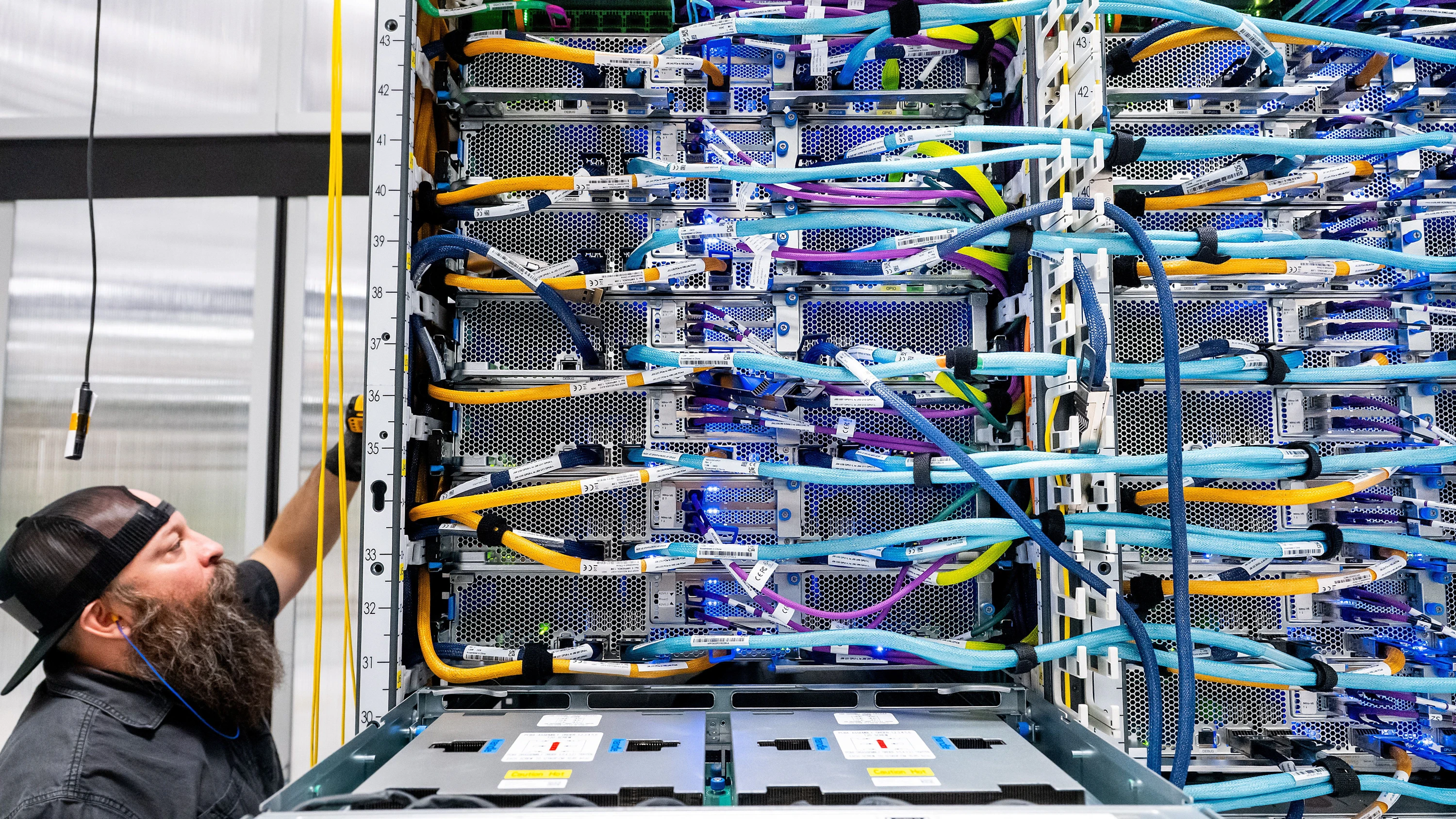

Technische Enabler formen heute viele Marktdynamiken: leistungsfähige APIs erlauben Echtzeit-Zugriff, Data Catalogs verbessern Auffindbarkeit, und Data Clean Rooms bieten sichere Umgebungen für die gemeinsame Analyse sensibler Daten ohne direkten Datenaustausch. Ebenso gewinnen Konzepte wie Data Unions und kooperative Datenpools an Bedeutung, in denen mehrere Dateninhaber ihre Ressourcen bündeln, um bessere Preise und stärkere Marktpositionen zu erzielen.

Die Rolle der Metadaten und Provenienz darf nicht unterschätzt werden: Käufer bewerten Daten zunehmend anhand von Herkunft, Erhebungsmethode, Aktualisierungszyklus und rechtlicher Nutzungsberechtigung. Entsprechende Nachweise — etwa Hashes, Signaturen oder Audit-Logs — erhöhen den Marktwert. Folglich ist Datenmanagement nicht nur technische Pflicht, sondern ein ökonomischer Hebel.

Regulatorische Rahmenbedingungen beeinflussen Angebot und Nachfrage stark. Datenschutzgesetze, Eigentumsrechte und Exportkontrollen können Marktzugänge beschränken oder neue Compliancekosten erzeugen. Gleichzeitig schaffen klare Regeln Vertrauen und damit Marktvolumen. Für Unternehmen heißt das: strategische Positionierung erfordert sowohl rechtliche Compliance als auch aktive Gestaltung von Daten-Governance.

Operational relevant für Entscheidungsfinder:innen sind folgende Handlungsfelder:

- Bewertung von Datenassets: Systematische Erfassung von Herkunft, Qualität, Nutzungseinschränkungen und Monetarisierungspotenzial.

- Auswahl von Vertriebskanälen: Direktverkauf vs. Plattform-Listing; Abwägung zwischen Reichweite und Kontrollverlust.

- Kooperationsstrategien: Bündnisse, Datenpools oder Lizenzmodelle mit Partnern, um skalenbasierte Vorteile zu realisieren.

- Technische Infrastruktur: Investition in APIs, Catalogs und Secure Environments, die den Marktzugang beschleunigen.

Strategien für datengestützte entscheidungen

Stellen Sie sich vor, jede Entscheidung hätte einen digitalen Schatten — eine Spur von Zahlen, die verrät, ob sie Erfolg haben wird. Wer diese Spur liest und richtig interpretiert, verwandelt Unsicherheit in kalkulierbares Risiko; wer es nicht tut, bleibt auf Intuition und Glück angewiesen.

Der erste praktische Schritt ist, Entscheidungen als produktive Prozesse zu begreifen, nicht als einmalige Urteile. Dazu gehört, Entscheidungsprozesse zu katalogisieren und zu priorisieren: Welche Entscheidungen sind wiederkehrend und volumenstark? Welche haben hohen Impact auf Umsatz, Kosten oder Compliance? Für jede priorisierte Entscheidung sollten Sie ein klar definiertes Outcome und messbare KPI festlegen — nicht bloß Dateninteresse, sondern konkrete Entscheidungsziele.

Arbeiten Sie mit einer Kombination aus drei analytischen Herangehensweisen:

- Deskriptiv: Was ist passiert? (Monitoring, Dashboards, Datenqualitätssignale)

- Diagnostisch: Warum ist es passiert? (Root-Cause-Analysen, Segmentierungen)

- Prognostisch/Präskriptiv: Was wird passieren und was sollen wir tun? (Forecasting, Optimierung, Entscheidungsregeln)

Hypothesengetriebenes Arbeiten ist essenziell: Formulieren Sie für jede datengetriebene Initiative klare Hypothesen (z. B. “Personalisierte Angebote erhöhen die Conversion um 12 %”) und definieren Sie Kriterien für Erfolg und Misserfolg. Validieren Sie Hypothesen zunächst mit kontrollierten Experimenten (A/B-Tests, Multi-Armed Bandits) oder, wenn Experimente nicht möglich sind, mit robusten quasi-experimentellen Methoden (Difference-in-Differences, Propensity Score Matching). Documentieren Sie Design, Randomisierung, Sample-Größe und statistische Power, um Fehlentscheidungen durch schlechte Versuchsanordnungen zu vermeiden.

Entscheidungen basieren nicht nur auf Korrelationen. Investieren Sie in Methoden zur Kausalitätsanalyse (Instrumentvariablen, natürliche Experimente, strukturelle Modelle), vor allem dort, wo operative Maßnahmen direkten Einfluss haben sollen. Machine-Learning-Modelle sind mächtig für Vorhersagen, aber ohne kausale Einordnung können Optimierungen fehlgeleitet sein — z. B. wenn ein Prädiktor indirekt Bias repräsentiert.

Operationalisieren Sie Daten als Entscheidungslogik durch folgenden Baukasten:

- Dataverträge und Datenprodukte: Definieren Sie klar, welche Datenpunkte, Modelle und APIs für welche Entscheidung benötigt werden. Legen Sie SLAs für Aktualität und Qualität fest.

- Feature- und Modell-Governance: Versionierung, Tests und Dokumentation für Features sowie Explainability-Metadaten für Modelle.

- Decision Pipelines: Automatisierte Abläufe von Datenaufnahme über Modellinferenz bis hin zur Aktionsauslösung und Feedback-Log. Integrieren Sie menschliche Prüfstellen dort, wo Risiken hoch sind.

Organisatorische Voraussetzungen sind mindestens genauso wichtig wie technische. Rollen und Verantwortlichkeiten sollten eindeutig geregelt sein: Data Owners (inhaltliche Verantwortung), Data Stewards (Qualität und Metadaten), Analytics Translators (Brücke zwischen Business und Data Science) und Decision Owners (operationalisieren und sign-off). Etablieren Sie regelmäßige Review-Zyklen, in denen Entscheidungseigner Metrik-Pipelines, Experimente und Modell-Performance bewerten.

Für eine robuste Umsetzung beachten Sie folgende Prinzipien:

- Fail fast, learn faster: Kleine, iterierbare Experimente bevorzugen vor monolithischen Projekten.

- Inkrementeller Wertnachweis: Messen Sie den marginalen Nutzen von Dateninvestitionen (Uplift, ROI pro Modell/Feature) statt nur Vanity-KPIs.

- End-to-End-Monitoring: Überwachen Sie nicht nur Modellaccuracy, sondern auch Daten-Drift, Concept-Drift, Latenz und Geschäftsmetriken.

- Transparenz und Explainability: Entscheidungsprozesse müssen nachvollziehbar sein, insbesondere bei regulatorisch sensiblen Use-Cases.

Bias- und Risikomanagement gehört in den Kern jeder datengetriebenen Entscheidungsstrategie. Implementieren Sie systematische Tests auf Verzerrungen (Disparate Impact, Fairness-Metriken), führen Sie regelmäßige Audits durch und dokumentieren Sie Eingriffe (Bias-Mitigationsmaßnahmen, Feature-Exklusionen). Kombinieren Sie automatische Checks mit menschlichen Reviews in multidisziplinären Panels, um unbeabsichtigte Nebeneffekte zu erkennen.

Technische Praktiken, die den Unterschied machen:

- Data Contracts: Verträge zwischen Datenproduzenten und -konsumenten sichern Kompatibilität und reduzieren Breakages im Betrieb.

- Feature Stores: Zentralisierte Repositories für produktionsreife Features mit Konsistenz zwischen Training und Serving.

- CI/CD für Modelle: Automatisierte Tests, Canary-Rollouts und schnelle Rollbacks ermöglichen stabile Releases.

- Observability: Traces, Metriken und Logs über Entscheidungs-Pipelines zur schnellen Fehlerdiagnose.

Reale Entscheidungen haben oft mehrere Stakeholder und unterschiedliche Zeithorizonte. Kombinieren Sie kurzfristige, operationelle Regeln (z. B. Realtime-Pricing, Fraud-Detection) mit langfristigen Strategien (Kapazitätsplanung, Produktentwicklung). Nutzen Sie Szenarioanalyse und Stresstests, um Robustheit gegenüber exogenen Schocks zu prüfen.

Ein pragmatischer Implementationspfad sieht typischerweise so aus:

- Identifizieren Sie 2–4 hochprioritäre Entscheidungen mit klaren KPIs.

- Entwickeln Sie für jede Entscheidung minimale Datenprodukte (Features, Dashboards, Modelle) innerhalb eines 6–12 Wochen-Sprints.

- Führen Sie kontrollierte Experimente oder A/B-Tests durch; messen Sie inkrementellen Wert.

- Operationalisieren Sie erfolgreiche Lösungen mit Data Contracts, Monitoring und klaren Rollen.

- Skalieren Sie nach standardisierten Playbooks und dokumentierten Lessons Learned.

Schließlich ist Datenkompetenz im gesamten Unternehmen ein Hebel: Schulen Sie Entscheidende in der Interpretation von Unsicherheit und Wahrscheinlichkeit, fördern Sie datengetriebene Diskussionen statt Meinungsdebatten, und belohnen Sie Entscheidungen, die durch Daten gestützt und transparent dokumentiert sind. Nur so werden Zahlen nicht nur informativ, sondern handlungsleitend.

Ethik und governance im umgang mit zahlen

Eine einzelne falsch interpretierte Zahl kann ganze Geschäftsmodelle kippen — und trotzdem passiert genau das täglich, weil Governance und Ethik oft als lästige Zusatzaufgabe behandelt werden.

Ethik und Governance sind keine Compliance-Extras, sondern operative Voraussetzungen dafür, dass Zahlen verlässlich, verantwortbar und gesellschaftlich akzeptiert verwendet werden können. Beginnen Sie mit klaren Prinzipien: Transparenz, Verantwortlichkeit, Datenschutz, Fairness und Nachvollziehbarkeit müssen in jede Datenstrategie eingebettet sein. Diese Prinzipien sind nicht bloß moralische Leitplanken; sie reduzieren rechtliche, finanzielle und reputative Risiken und erhöhen das Vertrauen von Kund:innen, Partner:innen und Regulator:innen.

Praktische Governance setzt an drei Ebenen an: Richtlinien & Prozesse, Organisation & Rollen sowie Technik & Kontrollen. Richtlinien definieren erlaubte Nutzungen, Datenklassifikationen, Aufbewahrungsfristen und Sanktionen bei Verstößen. Prozesse stellen sicher, dass Entscheidungen über Datennutzung formal geprüft werden (z. B. durch DPIAs oder Ethik-Reviews) und dass Änderungen an Datenprodukten versioniert und freigegeben werden.

- Richtlinien & Prozesse: Einführung von Datenklassifikationen, Purpose-Mapping (Wer darf Daten wofür nutzen?), verbindliche Prüfpfade für neue Use-Cases, regelmäßige Privacy-Impact-Assessments.

- Organisation & Rollen: Benennung eines Data Protection Officer (DPO), eines Chief Data Ethics Officer oder Ethik-Gremiums, klare Data Owner– und Data Steward-Verantwortlichkeiten sowie multidisziplinäre Review-Boards für risikobehaftete Projekte.

- Technik & Kontrollen: Implementierung von Access Controls, Verschlüsselung, Anonymisierung/Pseudonymisierung, Audit-Logs, Data Lineage und automatisierten Compliance-Checks.

Rechtliche Vorgaben wie die DSGVO sind Mindestanforderungen: Sie verpflichten zu Rechtmäßigkeit der Verarbeitung, Zweckbindung, Datenminimierung und Betroffenenrechten. Governance muss diese Anforderungen operationalisieren — z. B. durch Consent-Management-Systeme, Protokolle für Auskunftsersuchen und Prozesse zur Löschung oder Einschränkung der Verarbeitung. Ergänzend sind branchenspezifische Regeln und künftige Regulierungen (z. B. Algorithmenverordnungen) im Blick zu halten.

Modell- und Algorithmus-Governance verdient besondere Aufmerksamkeit: Transparenz allein reicht nicht. Implementieren Sie Modell-Karten (Model Cards) und Datasheets für Trainingsdaten, halten Sie Versionierung und Reproduzierbarkeit strikt ein und dokumentieren Sie Annahmen und Grenzen jeder Vorhersagekomponente. Führen Sie systematische Tests durch:

- Fairness-Checks: Disparate Impact, Equalized Odds oder gruppenspezifische Performance-Analysen.

- Robustheits- und Adversarial-Tests: Sensitivitätsanalysen, Stress-Szenarien, Red-Teaming.

- Explainability-Maßnahmen: Lokale und globale Erklärungen, die für Entscheidungsträger:innen verständlich sind.

Ethik ist oft mit Trade-offs verbunden: Mehr Transparenz kann Geschäftsgeheimnisse offenlegen, stärkere Anonymisierung reduziert analytischen Nutzen. Governance muss diese Trade-offs explizit machen und Entscheidungen dokumentieren — wer hat welchen Kompromiss gewichtet und warum? Solche Dokumentationen sind später entscheidend, wenn externe Prüfungen oder Vorfälle auftreten.

Kontrollen und Monitoring sind operativ: Implementieren Sie automatisierte Alerts für Anomalien in Datenpipelines (z. B. plötzliche Verschiebung in Demographie-Daten), regelmäßige Audit-Zyklen für Zugriffsrechte, sowie KPIs zur Governance-Performance (Anzahl DPIAs, Zeit bis Incident-Remediation, Anzahl korrigierter Bias-Funde). Audit-Logs und unveränderbare Protokolle (WAL/immutable logs oder Blockchain-Register für Provenienz) ermöglichen forensische Analysen.

Ein wirksames Incident- und Eskalationsmanagement umfasst klare Schritte: Detektion → Containment → Impact-Analyse → Benachrichtigung Betroffener/Regulatoren → Remediation → Lessons Learned. Definieren Sie SLAs für jede Phase und halten Sie Kommunikationsvorlagen bereit, um Verzögerungen und Unsicherheit zu vermeiden.

Technische Maßnahmen, die Governance stützen:

- Least Privilege & Role-Based Access: Minimale Rechte, just-in-time-Privilegien für sensible Analysen.

- Data Catalog & Lineage Tools: Sichtbarkeit über Herkunft, Transformationen und Nutzungspfad jeder Datenquelle.

- Secure Compute & Data Clean Rooms: Ermöglichen gemeinsame Analysen ohne Datenweitergabe.

- Consent Management & DPIA-Tools: Automatisierte Erfassung und Enforcement von Zustimmungen und Impact-Assessments.

- Observability & SIEM: Monitoring für Zugriffe, Anomalien und Compliance-Events.

Governance ist auch Kulturarbeit: Schulungen zu Datenschutz, Bias und ethischem Umgang mit Daten müssen regelmäßiger Bestandteil der Weiterbildung sein. Fördern Sie eine Atmosphäre, in der Mitarbeitende Probleme melden können, ohne Repressalien zu fürchten — ein anonymes Whistleblowing-Channel und Belohnungen für verantwortliches Handeln sind pragmatische Hebel.

Geld vernünftig ausgeben: Über die richtige Art von Sparsamkeit

Der Begriff Sparsamkeit bezieht sich nicht nur auf Geldangelegenheiten, sondern auf alles im Leben – den klugen Umgang mit der Zeit, den klugen Umgang mit der eigenen Fähigkeit, der eigenen Energie, und das bedeutet umsichtig zu leben, sorgfältige Lebensgewohnheiten. Sparsamkeit ist der wirtschaftliche Umgang mit sich selbst, mit seiner Zeit, mit seinen Angelegenheiten, mit seinem Geld, die vernünftigstmögliche Verwendung dessen, was wir von allen Ressourcen des Lebens haben.

Sparsamkeit ist nicht nur einer der Grundsteine für ein Vermögen, sondern auch die Grundlage für vieles, was eine hervorragende Eigenschaft hat. Sie verbessert die Möglichkeiten des Einzelnen. Die Ausübung der Sparsamkeit hat eine sehr gesunde Wirkung auf alle Fähigkeiten. Sparsamkeit ist in vielerlei Hinsicht ein Zeichen von Überlegenheit. Die Gewohnheit zur Sparsamkeit steht für Selbstbeherrschung. Sie ist ein Beweis dafür, dass der Mensch kein hoffnungsloses Opfer seiner Begierden, seiner Schwächen ist, sondern dass er Herr seiner selbst und seiner Finanzen ist.

Im Inhalt behandelte Punkte:

– Wirtschaft ist keine Schikane, sondern das planvolle Handeln zur Befriedigung von Bedürfnissen.

– Kapital ist der kleine Unterschied zwischen dem, was wir verdienen und dem, was wir ausgeben.

– Sparsamkeit ist nicht Geiz, sondern Vorsorge und die Art wie man sein Geld klug ausgibt.

– Falsche Sparsamkeit oder Verschwendung ist, wenn das Eingesparte weniger Wert ist, als der Aufwand, und das führt zur Armut.

– Ein kleiner Betrag, der regelmäßig über längere Zeit gespart wird, wächst zu einem Vermögen heran.

– Hinter jedem ehrlichen Vermögen steckt kluge Sparsamkeit.

– Man kann das gleiche Geld nicht zweimal ausgeben.

– Vertrauen genießt nur derjenige, der sein Geld vernünftig ausgibt, nicht aber derjenige, der es verschwendet.

– Glück ist eine geistige Einstellung, es ist der Zustand des Geistes, nicht der Zustand des Portemonnaies.

– Zeit ist kostbar. Nutze Sie die Zeit auf kluge Weise!

… u.a.

Es ist ein Buch mit wertvollen Ratschlägen, die jeder lesen sollte.

Strahlende Kräfte durch positives Denken

Aus dem Inhalt des Buchs:

– Charakter, Wille und Persönlichkeit

– Die Macht deiner Gedanken

– Vom Schaffen und vom Ruhen

– Die Verjüngung deines Lebens

– Die Kultur der Ruhe

– Sorgen, Ärger und Fluch überwinden

– Vom Seelenwert des Erlebens

– Die Heilkraft der Seele und des Willens

– Von den geistigen Verbindungen der Menschen

– Die Quellen der Wahrheit, Intuition und Inspiration

– Loslösung von innerlich Fremden

– Geistige Freiheit

– Der Weg zur Wahrheit

– Beherrsche dein Leben und dein Schicksal

– Das Geheimnis des Erfolgs

– Geistige Verjüngung

– Dem Schicksal trotzen

– Das Grundgesetz des Lebens

– Merksätze

Die letzten Ursachen

Die klassischen physikalischen Theorien, zum Beispiel die klassische Mechanik oder die Elektrodynamik, haben eine klare Interpretation. Den Symbolen der Theorie wie Ort, Geschwindigkeit, Kraft beziehungsweise Spannungen und Felder ist eine intuitive, klare Entsprechung in Experimenten zugeordnet. Anders sieht es bei einer der Säulen heutiger Welterkenntnis aus: der Quantenphysik. Da die Quantenphysik auf der sehr abstrakten Wellenfunktion basiert, kann eine Interpretation nicht mehr intuitiv erfolgen. Es liegt eine unzulässige Vermischung von Abstraktem mit Realem vor. Wenn man dagegen Abstraktes und Reales auseinanderhält, fällt es leichter zu einer realistischen Deutung von bisher schwer Verständlichem zu kommen. Hier findet die heutige Naturphilosophie eines ihrer reichhaltigen Betätigungsfelder. Sie versucht die Natur in ihrer Gesamtheit zu erfassen, ihre Strukturen zu beschreiben, anschaulich zu erklären und zu deuten.

Zudem gibt es neue Erkenntnisse, die es zulassen, eine naturwissenschaftliche Theorie über den transzendenten physikalischen Bereich, jenseits von Raum und Zeit aufzustellen. Das Werk eines Physikers, der die metaphysische Seite vom Jenseits beschreibt, schließt das “Buch der Naturerkenntnis” ab.

Insgesamt ist ein abgerundetes Werk über “Die letzten Ursachen” entstanden, das neben aktueller Erkenntnis die Weisheit der Jahrhunderte enthält und vielleicht sogar noch ein wenig von dem, was die Zukunft erst erweisen wird.

Konkrete Sofortmaßnahmen, die Entscheidungsfinder:innen umsetzen können:

- Starten Sie eine Inventur kritischer Datenprodukte und führen Sie für jede Kategorie eine DPIA durch.

- Etablieren Sie ein kleines Ethik- oder Review-Board mit klaren Entscheidungsbefugnissen.

- Implementieren Sie Data Lineage-Tracking und mindestens Basis-Audit-Logs für sensible Pipelines.

- Definieren Sie ein Set von Fairness- und Robustheitsmetriken, die bei jedem Modell-Release geprüft werden müssen.

- Schreiben Sie ein kurzes Playbook für Datenvorfälle inklusive Kommunikations- und Meldeprozessen.